Fin qui abbiamo compreso che esiste una grande parte del web (che supera, secondo le stime, l’80% del totale) non conosciuta ai normali motori di ricerca come Google e Bing.

Spesso si pensa erroneamente che i grandi motori di ricerca siano in grado di raggiungere tutte le risorse rese disponibili in rete, mentre la verità è che, in alcuni punti, gli spiders di Google e simili non riescono ad arrivare. In genere, infatti, non vengono quasi mai indicizzate le pagine che richiedono password per l’accesso, oppure quelle appartenenti a reti private, o ancora quelle generate dinamicamente a fronte di una query specifica. Inoltre, diverse pagine richiedono esplicitamente di essere escluse dai risultati delle ricerche.

Informazioni nascoste e motori di ricerca

Esistono quindi terabyte e terabye di informazioni, siti web, blog, forum e servizi che, per essere consultati e utilizzati, devono in primo luogo essere trovati mediante degli strumenti di ricerca specializzati per il Deep Web.

Occorre quindi ricordare che inizialmente il Deep Web si è evoluto per consentire una maggiore libertà di opinione e comunicazione, fornendo l’anonimato degli utenti che ne facevano utilizzo, sebbene purtroppo ormai rappresenta anche luogo di scambio per informazioni e servizi molto poco legali.

Anche i motori di ricerca per il Deep Web si sono specializzati di conseguenza e, pertanto, bisogna effettuare una selezione molto accurata degli strumenti da utilizzare e dei risultati di ricerca ai quali accedere.

In alcuni casi questi motori di ricerca dialogano con i servizi del Deep Web tramite rete TOR e risolvono gli indirizzi .onion, inviandoli al browser come output finali, alla stregua degli ordinari motori di ricerca Internet. Ovviamente è consigliato utilizzare i motori di ricerca mediante un browser web specializzato per il Deep Web e non utilizzare gli strumenti tradizionali al fine di ottimizzare la forma di anonimato desiderata.

Come detto, solitamente gli indirizzi a cui si fa riferimento quando si parla di Deep Web sono quelli ospitati dalla rete TOR e pertanto termiano con il suffisso .onion. Tuttavia il Deep Web non è costituito solo da URL della rete TOR, e dunque, per le finalità di questa guida, considereremo anche tutte quelle informazioni che per ragioni di varia natura non sono indicizzate dai classici motori di ricerca.

I motori del Deep Web

Fatte queste dovute premesse, diciamo che esistono moltissimi motori e strumenti di ricerca per accedere alle informazioni non indicizzate dai motori di ricerca tradizionali. Ognuno ha le sue caratteristiche e le sue regole. Ad esempio, alcuni sono specializzati per uno specifico ambito, ad esempio l’arte, mentre altri sono più generici e tentano di escludere in automatico dai risultati di ricerca i siti eticamente deplorevoli.

Alcuni noti motori di ricerca sono i seguenti:

Nello specifico, The WWW Virtual Library rappresenta il più vecchio catalogo sul Web, tanto da essere stato ideato dallo stesso Tim Berners-Lee, co-inventore insieme a Robert Cailliau del World Wide Web. Può sembrare strano che esso sia elencato tra i motori di ricerca del Deep Web, ma effettivamente contiene moltissime informazioni non catalogate altrove. Dispone di due possibilità di ricerca: una tramite la classica barra di ricerca, ed un'altra mediante navigazione in verticale, a partire da una categoria generale fino a scendere nel più piccolo particolare.

Surfwax si pone ad un livello differente rispetto ai classici motori di ricerca e intende fornire una vera e propria alternativa ad essi, offrendo un nuovo meccanismo di ricerca dinamica chiamato LookAhead. Il tutto si basa su un vocabolario controllato di parole, chiamato Lexicon, mediante il quale le informazioni vengono indicizzate e, lato utente, vengono mostrati dinamicamente dei termini per specializzare la ricerca. Si tratta tuttavia di un impegno bilaterale, ovvero che in parte deve essere compiuto dall’utente nell’utilizzare questa nuova forma di ricerca, mentre dall’altra deve essere utilizzata dal creatore del sito web per integrarvi i concetti necessari all’algoritmo di ricerca.

IceRocket è invece specializzato in ricerche real-time, ed è spesso utilizzato per la ricerca all’interno di blog. Lanciato nel 2004 e di provenienza americana, questo motore di ricerca nasce per facilitare le ricerche su PDA tramite e-mail, ma ora estende il suo raggio di azione a blog, Twitter e Facebook.

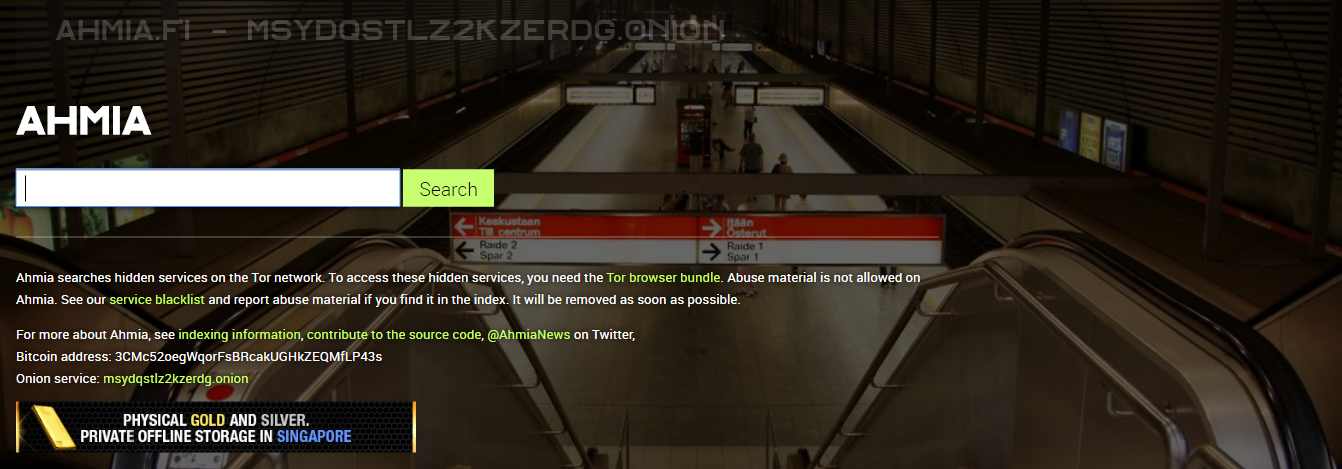

Ahmia costituisce uno dei motori per la ricerca dei servizi nascosti TOR. È stato creato da Juhna Nurmi e sviluppato nel 2014 nel corso del Google Summer of Code, con il supporto del Tor Project. Si tratta di un motore di ricerca open source che filtra in automatico alcune categorie di contenuti, come la pornografia di minori. Secondo le statistiche, a metà del 2015 indicizzava oltre 5000 siti e servizi ed ha contribuito all’individuazione di centinai di onion link fraudolenti presenti nel Dark Web.

Memex è un progetto lanciato dalla Defense Advance Research Projects Agency (DARPA) del governo degli Stati Uniti d'America, con l’obiettivo di essere da un lato uno strumento per tutti, in grado di rendere disponibile tutta quella massa utile di informazioni nascoste nel Deep Web, mentre dall’altro uno strumento del Governo americano per intercettare contenuti e attività malevole. Dopo essere stato per un lungo periodo in beta testing, lo stato del motore di ricerca è ancora incerto.

Blog per il Deep Web

È comunque importante ricordare che il Deep Web è costituito da tutte quelle informazioni che i motori di ricerca tradizionali non possono o non hanno convenienza ad indicizzare. Per questo motivo, oltre ad affidarsi a motori di ricerca secondari come quelli enunciati in questo articolo, gli utenti possono fare riferimento a numerosi blog dedicati alla diffusione di URL per l'accesso al Deep Web. Spesso infatti le risorse del Deep Web sono accessibili solo mediante URL dirette o tramite indirizzi che vengono periodicamente modificati e annunciati mediante un canale alternativo (come i blog, appunto), oppure facendo uso dei social o di particolari chat e servizi di messaging.