Premessa

Per seguire con profitto questa serie di articoli è consigliabile scaricare la versione gratuita di Windows Server 2012, la versione gratuita di System Center 2012 e ottenere una sottoscrizione a Windows Azure. Si possono facilmente utilizzare le versioni di prova messe gratuitamente a disposizione da Microsoft:

- Prova gratuita Windows Server 2012 R2

- Prova gratuita System Center 2012 R2

- Prova gratuita Windows Azure

Come il Cloud trasforma il datacenter

In un articolo del 2003 intitolato It Doesn’t matter Nicholas Carr, non ancora acclamato autore di libri di tecnologia, spiegava l’irrilevanza dell’innovazione tecnologica nella competitività di un’azienda. Il discorso di Carr era semplice: nel 2003 la disponibilità delle tecnologie IT era così standardizzata e diffusa che queste si stavano trasformando da potenziali risorse strategiche in commodity: “come il telefono o il motore a combustione – era il cuore del suo discorso –, quando una nuova tecnologia cresce e diventa ubiqua diventa una commodity e, da un punto di vista strategico, diventa invisibile e non ha più importanza: è quello che sta succedendo oggi all’information technology”. L’articolo provocò enorme reazioni nel mondo dell’informatica e un lungo dibattito in cui intervennero rappresentati delle più grandi aziende tecnologiche dell’epoca. Il CEO di Intel, Craig Barrett, fu il più duro definendo le tesi di Carr “pseudo-populismo”, mentre aziende che avevano investito centinaia di migliaia di dollari per costruire datacenter e altrettanti per gestirli e manutenerli caddero nello sconforto.

Lo scenario che Carr aveva delineato, tuttavia, emerse con chiarezza alcuni anni più tardi. Carr è infatti anche l’autore di The Big Switch, libro del 2008 in cui, cinque anni dopo aver demolito l’idea dell’IT come traino dell’innovazione, tornava sull’argomento per spiegare l’evoluzione del modello tecnologico e mostrare la portata rivoluzionaria del cloud computing. In questa seconda puntata, quello che era stato considerato il “nemico numero uno dell’IT”, spiegò il valore che la diffusione del Cloud ha introdotto nelle aziende: di fronte all’avanzare delle tecnologie cloud, “le aziende stanno ripensando il modo di comprare e usare le risorse informatiche. Piuttosto che investire grandi quantità di denaro in computer e software, stanno cominciando a ‘connettersi’ alla rete. Questo cambiamento non solo cambierà la natura dell’IT aziendale, ma sconvolgerà l’intera industria del computing”.

Carr aveva dunque compreso come il cloud computing sarebbe diventata un’onda lunghissima di innovazione che avrebbe ridefinito dalle basi il modo di intendere l’information technology. Questa ridefinizione del panorama porta con sé due semplici conseguenze: da un lato, grazie a questa nuova ondata di innovazioni, l’IT si sta trasformando di nuovo, da semplice commodity, in uno strumento di evoluzione e innovazione per le imprese. Dall’altro, proprio perché non più una commodity, la tecnologia diventa uno dei più importanti segmenti della strategia globale di un’azienda. In altre parole: l’IT può fare di nuovo la differenza in termini di agilità nel rispondere alle sollecitazioni del mercato, capacità di attrarre nuovi talenti, qualità e consistenza degli investimenti. Un’azienda che tardi oggi nell’analizzare come il cloud computing possa entrare a far parte non solo delle sue scelte tecnologiche, ma dell’intero mix di strategie che la guidano, accumulerà inevitabilmente un forte ritardo competitivo. Detto in altro modo: il cloud computing, se ci è permesso usare una metafora, preme con insistenza alle porte dei datacenter delle nostre aziende chiedendo a gran voce un cambiamento nei modi di programmare, gestire e operare l’IT. E lo richiede oggi.

Il cloud per il professionista IT

Gli artefici di questo cambiamento sono i professionisti IT, le figure che normalmente nelle aziende vengono identificate nei ruoli di CIO (Chief Information Officer) e CTO (Chief Technology Officer). Sono queste due figure ad essere coinvolte nelle principali sfide e che dovranno valutare, prima delle altre figure chiave di un’azienda, le strategie da adottare per affrontare il cambiamento in atto. Ne va, si potrebbe anche dire, della loro stessa sopravvivenza.

Il ruolo del professionista IT

Con l’avvento del cloud computing, il ruolo dei professionisti IT è messo ogni giorno in discussione. I professionisti delle tecnologie aziendali, abituati a scegliere, gestire e distribuire datacenter, software, servizi e dispositivi e a cercare di mantenerli sotto controllo, si stanno giorno dopo giorno accorgendo come la combinazione di cloud computing, diffusione dei dispositivi mobile e l’emergere delle necessità social anche a lavoro (condivisione, interazione ecc.) stiano irreversibilmente cambiando il modo di gestire le tecnologie all’interno dell’azienda. Sono almeno quattro i grandi ambiti in cui un professionista IT vede ridiscusso il suo ruolo e le sue competenze.

L’avanzata del software come servizio

In una impresa tradizionale è il dipartimento IT che guida i processi di selezione dei software da utilizzare e il modo con cui integrarli all’interno dell’infrastruttura aziendale. Se un dipartimento ha bisogno di un programma per gestire la posta elettronica oppure un CRM per gestire i clienti non può far altro che affidarsi al dipartimento IT e attendere che il sistema venga selezionato o acquistato, testato, configurato e distribuito. Oggi un servizio di posta elettronica di livello molto superiore a quello che si può trovare in centinaia di aziende di questo tipo è praticamente gratuito, mentre un servizio CRM di buona qualità costa qualche dollaro al mese. All’interno delle aziende ognuno, in altre parole, può trovare sul mercato e al di fuori dell’azienda software e servizi che non solo possono essere resi operativi con un semplice login, ma sono più funzionali e più usabili rispetto a quelli che il dipartimento IT può fornire. Ciò non solo porta alla disgregazione dei servizi IT, ma anche a problemi di sicurezza e di organizzazione del lavoro: come è possibile mantenere organizzato un dipartimento in cui i servizi sono distribuiti su decine di login diversi? In questo caso il ruolo dei professionisti IT diventa non tanto quello di provvedere alla distribuzione del software, quanto piuttosto quello di gestire l’integrazione dei servizi cloud all’interno dell’azienda, selezionare quelli più utili, stabilire linee di condotta, gestire le policy con flessibilità, cercare di dare omogeneità ad un panorama che diventa, e probabilmente, diventerà sempre meno standard e meno integrato.

L’avvento dei dispositivi consumer

L’influsso delle tecnologie “personali” su quelle “lavorative”, un fenomeno noto come “consumerizzazione dell’IT”, è evidente anche se ci spostiamo dall’ambito del software e dai servizi a quello dei dispositivi. Tradizionalmente era il dipartimento IT di un’azienda che procurava i dispositivi per i dipendenti. Oggi invece la diffusione dei dispositivi e così ampia e la linea di confine fra lavoro e vita personale è, per quanto riguarda le tecnologie utilizzate, così sfumata che sono sempre più numerosi i dipendenti che utilizzano al lavoro i propri dispositivi personali o a casa i propri dispositivi di lavoro. Frenare questa tendenza non è possibile, poiché conduce a maggiore soddisfazione dei dipendenti ed a maggiore produttività, ma soprattutto a nuovi problemi per l’IT aziendale che deve ripensare i sistemi di autenticazione, la sicurezza delle connessioni, la persistenza dei dati su dispositivi diversi. Anche in questo caso, CIO e CTO devono ripensare i propri ruoli e le proprie competenze.

Ogni azienda è una software company

L’enorme potenza di tecnologia a disposizione dei consumatori, a partire dal semplice smartphone che portiamo ogni giorno in tasca, ha come effetto quello di trasformare ogni azienda, anche quella più solidamente ancorata ad un mondo di brick and mortar, in una software company. Dall’ospedale che ha bisogno di gestire un servizio di prenotazioni online al produttore di interruttori per le luci di una domotica, dall’orologio che può essere connesso ad internet per monitorare le nostre camminate al termostato che vogliamo sia programmabile anche a distanza: ci aspettiamo ogni giorno di più che i servizi e i prodotti con cui interagiamo abbiano un’intelligenza informatica che ci permetta di gestirli nel modo più semplice possibile. In questo scenario, ai professionisti IT saranno richieste sempre più competenze per la creazione di quelle che possiamo chiamare modern application: applicazioni che devono essere integrabili con app per smartphone, che devono far uso del cloud per la gestione delle notifiche, che devono prevedere autenticazione e automazione, che possono far leva sui servizi dei social network.

I big data che generano innovazione

Se c’è una tendenza in grado di cambiare, in modo ancor più profondo di quello che abbiamo descritto sinora, il modo con cui l’IT può supportare lo sviluppo di business di un’azienda, questa è rappresentata dai cosiddetti “big data”. La capacità di elaborare un numero sempre più crescente di informazioni allo scopo di perfezionare un prodotto, rendere più efficiente un servizio, migliorare un processo oppure scoprire nuove opportunità di business, rende il modo dei big data un asset sempre più irrinunciabile. L’impatto di questa tendenza coinvolge più aspetti del lavoro di un professionista IT: sono necessarie non solo nuove procedure IT – pensiamo solo alla conservazione dei dati o alla creazione dell’infrastruttura hardware e software dedicata ad elaborarli –, ma sono necessarie anche nuove competenze che spaziano dall’informatica alla matematica alla statistica e che sono riassumibili in quella che qualcuno chiama la data science, una disciplina che sarà sempre più decisiva nell’organizzazione tecnologica di un’azienda.

Il professionista IT oggi

In molti pensano che di fronte all’onda lunga del Cloud il ruolo del professionista IT sia ridimensionato. Se infrastrutture, piattaforme e software vengono elaborati nel Cloud, è la semplicistica induzione, chi gestisce le piattaforme on premise avrà ruoli sempre più marginali. In realtà e vero il contrario. Anche dalla breve descrizione dei quattro ambiti di trasformazione che abbiamo indicato sopra, emerge come il Cloud, se non governato, rischia di introdurre in azienda più complessità che standardizzazione, più costi che risparmi. Il ruolo del professionista IT in questo campo è dunque quello di prevedere l’emergere di queste nuove tecnologie, governare la proliferazione dei servizi, dei dispositivi, delle informazioni e delle nuove tecnologie, avendo sempre come punto di riferimento la visione strategica dell’azienda di cui è parte.

Sbagliato sarebbe, in un vano tentativo di difendere il proprio ruolo, chiudere la porta all’avanzare del Cloud: il professionista IT deve farsi anche intermediario fra le tecnologie distribuite dall’interno e le tecnologie erogate dal Cloud sapendo scegliere, di volta in volta, il giusto fornitore, sapendo conciliare le policy aziendali e la giusta richiesta di agilità e flessibilità, sapendo riconoscere quando una nuova tecnologia migliora i processi aziendali e quando invece li rende più farraginosi.

L’IT, come abbiamo accennato ad inizio di questo articolo, non è più una semplice commodity, ma sta ritrovando il suo ruolo di vettore d’innovazione dell’impresa ed è sempre più strettamente connessa ai processi decisionali più profondi. In questa transizione, il ruolo del professionista IT non è secondario, ma diventa cruciale nel supportare la strategia globale dell’azienda. Ma come può un professionista IT venire incontro a questi cambiamenti? Lo vedremo nella prossima parte dell’articolo.

Dalla virtualizzazione al Cloud OS

Nella prima parte di questo articolo abbiamo delineato quali sono le sfide che l’IT moderna ha messo di fronte ai CIO e ai CTO. Abbiamo parlato di come il software si stia sempre di più trasformando in un servizio, abbiamo visto come sia sempre più evidente la tendenza a gestire all’interno dei datacenter anche dispositivi consumer, abbiamo sottolineato che ogni azienda, in un’epoca di maggiore interconnessione e pervasività delle tecnologie, dovrà prima o poi trasformarsi in una software company e abbiamo, infine, analizzato come i big data diventeranno centrali nell’elaborazione di una strategia IT aziendale che sappia supportare l’evoluzione della strategia globale dell’impresa.

In questa e nella successiva sezione vedremo invece, in pratica, quali sono le tecnologie di base a disposizione del professionista IT per affrontare queste sfide. Quali sono, in altre parole, le tecnologie che servono ad abilitare l’infrastruttura di base necessaria a costruire il Cloud OS.

Foundation: la virtualizzazione

Tra gli aspetti fondamentali dell’IT di oggi e dell’IT del futuro vi è, come dovrebbe essere chiaro a chiunque gestisca un reparto IT, la virtualizzazione. Questa tecnologia, applicata ai server, allo storage e alle reti, ha permesso di introdurre, tra le altre cose, quel set di caratteristiche su cui costruire servizi di Cloud Computing.

La virtualizzazione non è una tecnologia nuova, ma il suo impatto nell’IT è fondamentale. Ciò che fa la virtualizzazione è molto semplice: astrae le risorse fisiche del datacenter in modo da creare risorse logiche che, proprio perché astratte dalla loro base fisica, possono essere, da un lato, gestite in modo più efficace – spostate, copiate, raggruppate – e, dall’altro, consolidate in un numero minore di supporti fisici. Poiché non è una tecnologia nuova, è supportata da tecnologie mature, di facile acquisizione sul mercato e flessibili a tal punto da potersi adattare facilmente a qualsiasi tipo di configurazione. È inoltre una tecnologia semplice da implementare nel proprio datacenter o all’interno della rete della propria azienda e può essere utile per diverse finalità: dal consolidamento di vecchi server, alla gestione di desktop virtuali alla riduzione delle macchine per risparmiare spazio o consumare meno energia elettrica.

Sebbene sia una tecnologia semplice da implementare e possa portare diversi vantaggi a chi la utilizza, tra le piccole e medie imprese del nostro paese, e non solo, la sua adozione è ancora limitata. Ciò non solo riduce l’innovazione, ma preclude la transizione verso il paradigma di gestione dell’IT che rappresenta il modello più efficiente disponibile: il Cloud OS. Cerchiamo dunque di evidenziare i tanti vantaggi che si ottengono dall’uso della virtualizzazione con il proposito di evidenziare le migliori pratiche in questo campo e cominciare a toccare con mano i vantaggi che si ottengono con un approccio strutturato all’ottimizzazione dell’IT.

Riduzione dei costi

Il primo vantaggio che si ottiene introducendo nella propria infrastruttura delle tecnologie di virtualizzazione è legato alla riduzione dei costi. Con la virtualizzazione un’azienda può ridurre il numero di server fisici e andare a incidere sia sulla spesa capitale, tipicamente associata in questo caso all’acquisizione dell’hardware, sia sulla spesa operativa, spesa legata ai consumi di energia elettrica necessaria per mantenere in funzione l’infrastruttura.

Aumento della competitività dell’azienda

La virtualizzazione permette di aumentare la capacità computazionale di un datacenter senza incorrere in grandi investimenti. Pensiamo ad una piccola e media impresa: per erogare un servizio che ha bisogno, poniamo, di un server database, un server web, un server per l’autenticazione e gestione di identità e un server per la conservazione dei file, non ha più necessità di usare quattro differenti macchine. Con la virtualizzazione posso erogare lo stesso servizio utilizzando un’unica macchina, non solo risparmiando nei costi, ma soprattutto potendo ampliare la capacità computazionale necessaria all’erogazione del servizio senza dover incorrere in grandi costi infrastrutturali. Con la virtualizzazione una PMI può, in altre parole, raggiungere con una certa facilità la capacità IT che le consente di competere con le grandi aziende.

Aumento della flessibilità e dell’efficienza del datacenter

La virtualizzazione aumenta l’efficienza e la flessibilità di un datacenter. Virtualizzazione non riguarda solo i server, ma è un’astrazione di tutte le risorse che si utilizzano in un datacenter: storage, network e macchine virtuali. Considerando che, in genere, le risorse IT di un dipartimento non virtualizzato sono utilizzate per il 20 per cento delle loro potenzialità, spostando queste risorse in un ambiente virtualizzato è possibile ad aumentare il loro tasso di utilizzo e, di conseguenza, aumentare efficienza e flessibilità.

Consolidamento delle risorse

La virtualizzazione permette di affrontare il problema della disomogeneità delle infrastrutture IT. Non è raro trovare in aziende, sia piccole sia grandi, una gamma poco coerente di server, apparati di rete, dispositivi di archiviazione, aggiunti all’infrastruttura nel tempo adottando criteri differenti. Un’infrastruttura poco omogenea rende difficile non solo la gestione, ma anche l’adozione, per fare un esempio, di semplici procedure di backup. In questi casi la virtualizzazione permette, con piccoli investimenti e senza complesse procedure di configurazione, di consolidare le risorse, riducendo l’hardware e semplificando in generale tutto il sistema.

Scegliere il giusto hypervisor

La virtualizzazione rappresenta dunque le fondamenta su cui costruire un’infrastruttura IT moderna. Per questo motivo è importante, al momento di progettare l’infrastruttura, scegliere il giusto hypervisor, il componente che si occupa di abilitare le tecnologie di virtualizzazione. L’hypervisor deve essere affidabile, capace, flessibile. Ma soprattutto deve essere integrato in un ecosistema che ne permette di gestire le capacità, di monitorarne le operazioni, di automatizzarne le funzioni: al crescere della base di elementi virtualizzati, avere un hypervisor che non offre queste caratteristiche potrebbero compromettere l’intera infrastruttura.

Hyper-V integrato in Windows Server 2012 R2 rappresenta lo stato dell’arte degli hypervisor. Analizzando le sue caratteristiche è possibile farsi un’idea di come deve composto questo fondamentale componente IT. Un hypervisor deve essere in primo luogo scalabile: Hyper-V supporta cluster composti da 64 nodi in cui possono essere ospitate fino ad 8000 virtual machine; le singole virtual machine possono essere configurate per supportare fino a 64 CPU, 1 TB di Ram e 64 TB di disco. La capacità di mantenere la qualità del servizio prevista dagli utenti deve essere garantita da tecnologie di alta affidabilità in grado di azzerare o ridurre il tempo di downtime: Hyper-V supporta la mobilità a caldo delle virtual machine e dello storage attraverso la funzione di Live Migration che, nelle ultime versioni, è stata estesa attraverso la Shared Nothing Live Migration che offre la possibilità di spostare una virtual machine verso un altro host, mantenendo funzionanti i servizi, attraverso una semplice connessione di rete. Un hypervisor deve essere anche in grado di gestire con la stessa semplicità anche l’astrazione della rete. Hyper-V affronta questo problema con la network virtualization: è possibile virtualizzare lo stack di rete cosa che, tra le altre cose, rende molto più comodo spostare delle virtual machine tra datacenter diversi. Infine, un hypervisor deve poter supportare le diverse tecnologie, in termini di sistemi operativi, server, apparati di rete, dispositivi di storage, utilizzate all’interno delle aziende. Hyper-V permette di ospitare server Windows o server Linux e il supporto alle tecnologie di storage è stato ampliato grazie alla possibilità di salvare hard disk virtuali anche su cartelle condivise in rete (attraverso il protocollo SMB) senza, dunque, ricorrere a costose soluzioni di Storage Area Network (SAN).

Dalla virtualizzazione al Cloud OS

Come abbiamo indicato ad inizio articolo, la virtualizzazione rappresenta la base, le fondamenta di un’infrastruttura IT moderna. Il percorso di evoluzione da un datacenter tradizionale ad uno virtualizzato deve tenere conto tuttavia anche degli aspetti legati al monitoraggio e alla gestione dell’intera infrastruttura. Una volta introdotte le tecnologie di virtualizzazione è normale, ed è una tendenze certificata anche dalle maggiori società di analisi, che il numero di macchine virtuali tenderà ad aumentare esponenzialmente. A mano a mano che aumentano le macchine virtuali, i professionisti IT devono anche essere anche in grado di gestirle e monitorarle attraverso sistemi coerenti ed integrati.

In un datacenter virtualizzato, in cui l’astrazione delle risorse non è limitata ai soli server, ma coinvolge anche i dispositivi di storage o le reti, diventa quasi naturale cercare una soluzione che riesca, da un lato, a semplificare la gestione di questa infrastruttura virtualizzata, dall’altro, ad attivare funzionalità aggiuntive, come ad esempio il monitoraggio di tutte le risorse, l’automazione dei processi più ripetitivi e quotidiani, la gestione della disponibilità dei servizi. Si tratta di un processo che deve essere pianificato e gestito a medio o lungo termine, ma che se ben implementato porta non solo ad aumentare l’efficienza dell’IT, e dunque, anche la competitività dell’azienda e la capacità di adattarsi all’evoluzione del proprio modello di business, ma anche a risparmiare sui costi di acquisizione e di gestione dell’intera infrastruttura.

Oltre la virtualizzazione c’è dunque un altro passo da compiere. Applicando, al di sopra del livello di virtualizzazione, un ulteriore livello che permette di organizzare tutte le diverse risorse come se fossero un unico organismo, si scala un ulteriore gradino verso la costruzione di un IT che sappia affrontare con affidabilità i cambiamenti di cui abbiamo ampiamento parlato. Questo gradino ci porta al cuore dell’IT moderna, ci porta al Cloud OS. Di questa infrastruttura parleremo nella terza e ultima parte di questo articolo.

Le necessità di un’infrastruttura IT moderna

Dalle indicazioni che abbiamo fornito nelle pagine precedenti dovrebbe essere chiaro come la necessità di trasformare il proprio datacenter e, più in generale, quella di ripensare il proprio approccio con l’IT, non è solamente una delle possibilità che si presentano al professionista IT, ma è l’unica opportunità che CIO e CTO hanno in mano per arginare l’ondata di cambiamento, quella che abbiamo chiamato il big switch, che si sta abbattendo sulle infrastrutture IT tradizionali.

In quest’ultima parte dell’articolo vorremmo, prima di passare alle parti più pratiche, fornire una sorta di radiografia sintetica di quali sono i vari livelli da considerare quando si progetta un datacenter moderno, livelli che devono essere abilitati da software specifici, software che, come vedremo, devono essere consistenti e coerenti.

I livelli di un datacenter moderno

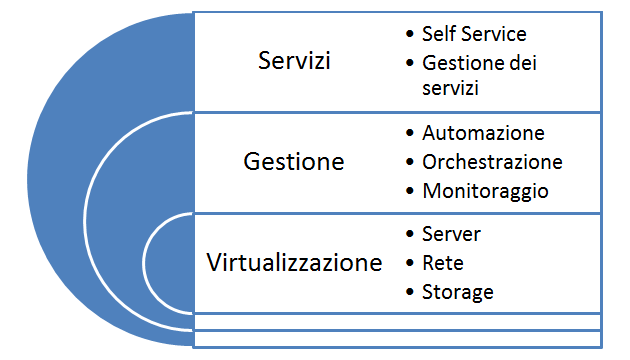

Lasciamoci aiutare da una grafica per analizzare i singoli elementi che compongono le sezioni hardware e software di un datacenter moderno.

I livelli di funzionalità di un moderno Cloud OS

L’architettura di un tale tipo di datacenter ha alle sue basi, come abbiamo avuto più volte modo di ripetere, la virtualizzazione. Attraverso la virtualizzazione possiamo astrarre tutte le risorse fisiche del nostro datacenter (i server, i dispositivi di storage, le reti) e gestirle come un organismo unico. Ciò permette di costruire, al di sopra del livello di virtualizzazione, un ulteriore livello che, per semplificare, abbiamo chiamato “di gestione” che, da un lato, rende più semplice gestire il nostro datacenter e, dall’altro, consente di abilitare una serie di servizi come l’automazione, il monitoraggio o l’orchestrazione del datacenter, servizi che, a loro volta, aprono le porte alle più complete tecnologie di cloud computing. Solo unendo alla virtualizzazione un completo sistema di gestione del datacenter possiamo, ad esempio, gestire in un unico sistema macchine virtuali eterogenee, sostenere processi automatici di sostituzione di macchine virtuali, scalare, verso l’alto o verso il basso, le risorse in base ai carichi di lavoro. Analizziamo dunque in dettaglio questi ulteriori livelli.

Automazione

Il livello di automazione è il livello che permette di rendere automatiche le attività IT nel tempo. I servizi che fano parte di questo livello devono, ad esempio, essere in grado di gestire in modo automatico gli incidenti che possono verificarsi all’interno di un datacenter. Immaginiamo che siano le due di notte e il datacenter ha un problema in un servizio critico. Il primo livello di intervento deve essere creato, senza occupare fisicamente il team IT, dal livello di automazione: un software, opportunamente preimpostato, deve essere in grado, ricevuto l'allarme, di eseguire i classici task di ripristino del servizio che vengono eseguiti normalmente a mano dal team IT. Il software dunque riavvia il servizio, riavvia il server, verifica se il servizio è di nuovo online e, se i tentativi automatici non dovessero andare a buon fine, invia un alert urgente all'amministratore IT. Questa è naturalmente solo una delle attività che dovrebbe essere gestita dal livello di automazione: un software di questo tipo dovrebbe essere in grado di creare e configurare virtual machine senza l’intervento umano, gestire database, eseguire le procedure di aggiornamento, aggiungere o rimuovere potenza in base alle necessità e così via.

Orchestrazione

L’automazione non sarebbe possibile se non esistesse, all’interno del datacenter, un servizio in grado di armonizzare i vari sistemi e dispositivi disponibili. L’orchestrazione in un datacenter è quel livello critico di gestione che consente di eseguire, preferibilmente da un unico software e da un’unica interfaccia, una lunga serie di attività su più sistemi, servizi o dispositivi. Proprio per questa sua funzione, il livello di orchestrazione è, in un certo senso, il ponte i tra livelli superiori e le risorse virtualizzate. In genere il livello di orchestrazione si compone di una serie di connettori che permettono di sfruttare i servizi presenti all’interno di un datacenter, siano essi hardware o hardware virtualizzato (connettori per l’hypervisor, connettori per i dispositivi di storage, connettori per gli switch di rete), siano essi software (sistemi operativi o altro software di gestione). I connettori sono in grado di eseguire azioni sui sistemi che controllano. Per organizzare le operazioni, un sistema di orchestrazione deve anche essere in grado di stabilire relazioni fra i diversi servizi. In questo caso si utilizzano processi o workflow specifici che, nei servizi a più alto valore aggiunto, sono gestibili attraverso semplici interfacce grafiche.

Monitoraggio

Altro tassello necessario nella creazione di un’infrastruttura IT moderna è il servizio di monitoraggio dell’infrastruttura. In questo caso, più che nei livelli precedenti, è un servizio che probabilmente è già presente in ogni infrastruttura IT. Ma il monitoraggio che serve in un datacenter moderno è cosa ben diversa da quello presente in un datacenter tradizionale. Nell’IT del futuro è necessario che il monitoraggio non verifichi solo il livello di funzionamento di dischi, server, cpu, ma anche la qualità del servizio che l’intera infrastruttura, nel suo insieme, riesce ad erogare. Il monitoraggio, in altre parole, si estende dal controllo delle perfomance dell’hardware, al controllo delle performance percepite dagli utenti che usano i servizi erogati da quell’hardware. In questo scenario gli elementi da monitorare crescono in numero e complessità: è necessario prevedere sensori che riescono a verificare quando un’applicazione non risponde come dovrebbe alle interazioni degli utenti, quando il database non riesce ad erogare informazioni con la qualità del servizio richiesta, quando un errore di programmazione rende indisponibile una funzionalità.

Una piattaforma consistente per il Cloud OS

Una delle necessità dell’IT è sempre stata quella di limitare i costi legati all’operatività dell’infrastruttura. Per abilitare i livelli che abbiamo delineato velocemente nei paragrafi precedenti è necessario, naturalmente, aggiungere nuovi software e nuovi servizi. Si potrebbe pensare che ciò comporti un aumento della complessità dell’infrastruttura, e dunque un aumento dei costi necessaria a gestirla. Tuttavia si pensi a come siano improduttive tutte le attività che prevedono configurazioni, installazione di aggiornamenti, interventi per la risoluzione dei problemi: sono attività che consumano tempo e che impediscono ai professionisti IT di dedicarsi ad operazioni più strategiche per l’azienda.

In questo modello diventa dunque decisiva la scelta delle giuste tecnologie utilizzate nel proprio datacenter. Quando si deve scegliere il software che gestisce un’infrastruttura IT moderna è indispensabile guardare con attenzione non solo al numero di strumenti che possono essere sfruttati, ma anche alla semplicità delle operazioni di configurazione e manutenzione necessarie a gestire questi strumenti. I software che abilitano i livelli di cui abbiamo parlato devono essere integrati fra loro, offrire interfacce coerenti, permettere integrazioni con le infrastrutture esistenti senza aggiungere complessità.

Quando si parla di IT moderna, quando si parla di Cloud OS, la proposta di Microsoft ha un indubbio vantaggio: quello di offrire un piattaforma consistente in grado di gestire tutti i livelli che abbiamo descritto in queste pagine. Il Cloud OS di Microsoft si compone sostanzialmente di tre singoli prodotti, perfettamente integrabili l’uno con l’altro: Windows Server 2012 R2 come sistema di base per la virtualizzazione e la gestione del datacenter, System Center 2012 R2 per abilitare i servizi di monitoraggio, automazione, orchestrazione e il Cloud privato e Windows Azure come supporto per il Cloud pubblico e il Cloud ibrido. È, giova ripeterlo, una piattaforma consistente, piattaforma che vedremo in dettaglio nel prossimo articolo di questo nostro viaggio nel Cloud OS.